Inteligencia Artificial, ¿en qué piensas?

Qué significa realmente 'inteligencia' y cómo entrenar tanto la nuestra como la de las tecnologías que usamos. Porque no todo lo que suena inteligente lo es.

Hace unos días publiqué en mi perfil de LinkedIn ‘The illusion of Thinking’, un paper firmado por varios miembros del equipo de IA de Apple que analizan si la Inteligencia Artificial, y más concretamente los LLM’s, piensan o sólo lo parece. Y después de leerlo con atención…

… resulta que bajo esta superficie de ‘brilli brilli’ se esconde una realidad: ‘la elocuencia no es inteligencia e imitación no es comprensión’.

El paper demuestra que incluso los modelos de razonamiento más sofisticados carecen fundamentalmente de auténticas capacidades cognitivas. Y al César lo que es del César, es algo que investigadores como Yann LeCun, científico jefe de IA de Meta, llevan mucho tiempo sosteniendo: estamos antes ‘sofisticadas máquinas que emparejan patrones y no entidades pensantes’. Algo así como ‘estadística con esteroides’.

Las conclusiones del equipo de investigación de Apple son metódicas y condenatorias. Al crear entornos de rompecabezas controlados que podían manipular con precisión la complejidad al tiempo que mantenían la coherencia lógica, revelaron tres regímenes de rendimiento distintos en los grandes modelos de razonamiento. En tareas de baja complejidad, los modelos estándar superaron a sus homólogos de razonamiento supuestamente superiores. Los problemas de complejidad media mostraron beneficios marginales de los procesos de ‘pensamiento’ adicionales. Pero lo más revelador es que ambos tipos de modelos experimentaron un colapso total cuando se enfrentaron a tareas de alta complejidad.

Lo que hace que estos resultados sean especialmente sorprendentes es el comportamiento de escalado contraintuitivo que observaron los investigadores. En lugar de mejorar con el aumento de la complejidad, como haría una inteligencia genuina, estos modelos mostraban un patrón peculiar: su esfuerzo de razonamiento aumentaba hasta cierto punto y luego disminuía drásticamente a pesar de contar con los recursos computacionales adecuados. Esto sugiere que, en realidad, los modelos no razonaban, sino que seguían patrones aprendidos que se rompían al enfrentarse a nuevos retos.

El estudio pone de manifiesto las limitaciones fundamentales del cálculo exacto, revelando que estos sistemas no utilizan algoritmos explícitos y razonan de forma incoherente en rompecabezas similares. Cuando se le quita el barniz de lenguaje sofisticado, lo que queda es una sofisticada pero hueca imitación del pensamiento.

Estos resultados coinciden perfectamente con las advertencias que Yann LeCun y otros destacados investigadores de la IA llevan años lanzando. LeCun siempre ha afirmado que los LLM actuales quedarán obsoletos en un plazo de cinco años, no porque vayan a ser sustituidos por versiones mejores de la misma tecnología, sino porque representan un enfoque fundamentalmente erróneo de la inteligencia artificial.

El problema principal no es la destreza técnica, sino conceptual. Como decía antes, estos sistemas no entienden, sino que siguen patrones. No razonan, sino que interpolan a partir de datos de entrenamiento. No piensan, sino que generan respuestas estadísticamente probables a partir de conjuntos de datos masivos. La sofisticación de sus resultados enmascara la ausencia de comprensión genuina, creando lo que los investigadores reconocen ahora como una elaborada ilusión de inteligencia.

Esta desconexión entre apariencia y realidad tiene profundas implicaciones para la forma en que evaluamos e implantamos los sistemas de IA. Cuando confundimos fluidez con comprensión, corremos el riesgo de tomar decisiones críticas basadas en procesos de razonamiento fundamentalmente erróneos. El peligro no es sólo tecnológico, sino epistemológico.

Paralelismos humanos: Nuestro sesgo hacia la elocuencia confiada

Quizá lo más inquietante sea lo mucho que esta limitación de la IA refleja un sesgo cognitivo humano persistente. Al igual que nos engañan las respuestas elocuentes de la IA, sobrevaloramos sistemáticamente la confianza y la extroversión humanas, confundiendo a menudo la facilidad verbal con la profundidad intelectual.

El sesgo del exceso de confianza representa uno de los defectos más generalizados del juicio humano, en el que la confianza subjetiva de los individuos en sus capacidades supera con creces su precisión objetiva. Este sesgo es especialmente pronunciado en entornos sociales y profesionales, donde las personas extrovertidas y seguras de sí mismas suelen atraer una atención y una credibilidad desproporcionadas.

Las investigaciones demuestran que tendemos a equiparar confianza con competencia, volumen con valor y articulación con inteligencia. La persona extrovertida que habla primero y con más frecuencia en las reuniones suele influir en las decisiones del grupo, independientemente de la calidad de sus ideas. El presentador seguro de sí mismo que ofrece un análisis pulido pero superficial suele recibir una evaluación más positiva que el introvertido reflexivo que ofrece ideas más profundas con menos estilo teatral.

Esta tendencia psicológica crea un peligroso bucle de retroalimentación. Las personas con poca capacidad suelen sobrestimar su competencia (efecto Dunning-Kruger), mientras que las que tienen auténticos conocimientos especializados pueden expresar la incertidumbre adecuada sobre cuestiones complejas. El resultado es una inversión sistemática de la credibilidad, en la que los que menos saben hablan con la mayor confianza, mientras que los que más entienden se comunican con los matices y las reservas adecuadas.

La convergencia de las ilusiones artificiales y humanas

El paralelismo entre la elocuente vacuidad de la IA y nuestro sesgo hacia la comunicación confiada revela algo profundo sobre la propia naturaleza de la inteligencia. Ambos fenómenos demuestran con qué facilidad confundimos la apariencia de comprensión con su sustancia. Ambos muestran cómo una comunicación sofisticada puede enmascarar limitaciones fundamentales en el razonamiento y la comprensión.

Consideremos las implicaciones para la toma de decisiones organizativas, la evaluación educativa y la dinámica social. Si sobrevaloramos sistemáticamente la presentación segura frente al análisis cuidadoso, ya sea de sistemas de inteligencia artificial o de colegas humanos, degradamos sistemáticamente la calidad de nuestro razonamiento colectivo. Creamos entornos en los que la representación teatral prima sobre la auténtica resolución de problemas.

La revelación del paper de Apple de que los modelos de razonamiento de IA fracasan cuando se enfrentan a la verdadera complejidad refleja cómo las personas demasiado seguras de sí mismas a menudo tienen dificultades con problemas realmente difíciles mientras mantienen su apariencia persuasiva. Ambas representan formas sofisticadas de impostura intelectual que pueden persistir precisamente porque son tan convincentes en apariencia.

Más allá de las ilusiones: Reconocer la inteligencia genuina

Comprender estas limitaciones, tanto artificiales como humanas, abre la puerta a una evaluación más auténtica de la inteligencia y el razonamiento. La verdadera inteligencia no se caracteriza por una confianza inquebrantable o una presentación elocuente. En cambio, se manifiesta de varias maneras clave.

La auténtica inteligencia acepta la incertidumbre cuando se enfrenta a problemas complejos. Reconoce sus limitaciones en lugar de ocultarlas. Demuestra un razonamiento coherente en diferentes contextos, en lugar de derrumbarse cuando los patrones le resultan desconocidos. Y lo que es más importante, demuestra una comprensión genuina a través de la capacidad de adaptar principios a situaciones nuevas.

En contextos humanos, esto significa mirar más allá de la presentación carismática para evaluar la calidad subyacente del razonamiento. Significa crear espacio para respuestas meditadas y reflexivas, en lugar de recompensar únicamente las respuestas rápidas y seguras. Significa reconocer que las ideas más profundas a menudo vienen envueltas en la humildad adecuada, más que en la certeza absoluta.

Para los sistemas de IA, significa desarrollar marcos de evaluación más rigurosos que pongan a prueba la comprensión genuina en lugar de la coincidencia de patrones. Significa reconocer las limitaciones actuales en lugar de antropomorfizar la generación de textos sofisticados. Significa construir sistemas que puedan razonar de verdad en lugar de simplemente parecer que lo hacen.

Dicho esto, la convergencia de los resultados de la IA de Apple con la investigación psicológica sobre los sesgos humanos ofrece una valiosa orientación para navegar por nuestro mundo cada vez más complejo. Tanto si evaluamos sistemas de IA como a colegas humanos, debemos aprender a distinguir entre rendimiento y competencia, entre elocuencia y comprensión.

Para ello es necesario cultivar la humildad intelectual, es decir, reconocer que la inteligencia genuina suele ir acompañada de la incertidumbre adecuada, que las voces más seguras no son necesariamente las más creíbles y que la verdadera comprensión puede distinguirse de la imitación sofisticada mediante la observación cuidadosa y la puesta a prueba.

Y para distinguir la inteligencia de la imitación en un entorno infundido de IA necesitamos invertir en inteligencia híbrida, que surge de la complementariedad de las inteligencias natural y artificial, anclada en la fuerza y las limitaciones de ambas.

Sí, la doble alfabetización, el dominio de la inteligencia artificial y natural de forma complementaria, ya no es opcional. A medida que la IA se entrelaza más profundamente con la vida cotidiana, las personas, las comunidades y las sociedades enteras deben aprender a relacionarse con la inteligencia de las máquinas desde una posición de conciencia y agencia. Pero, ¿de qué hablo? ¿qué es la inteligencia natural?

A ver, para comprender plenamente la importancia de la doble alfabetización, primero debemos definir lo que implica la inteligencia natural. La Inteligencia Natural no es simplemente cognición; es una composición de 2 x 4 dimensiones:

Aspiración, Emoción, Pensamiento y Sensación son los cuatro componentes básicos de la inteligencia individual. La aspiración da forma a los objetivos a largo plazo, la emoción influye en la toma de decisiones, el pensamiento estructura la lógica y el aprendizaje, y la sensación fundamenta la percepción y la experiencia.

Persona, Comunidad, País y Planeta son las cuatro dimensiones colectivas de la inteligencia. Los individuos no están aislados; están integrados en comunidades, moldeados por políticas nacionales e influidos por sistemas globales. Los ámbitos micro, meso, macro y meta se influyen mutuamente, así como el conjunto del que forman parte. Todo está conectado en un continuo de cambio constante.

Una comprensión holística esto significa entender que la inteligencia no es puramente individual ni únicamente cognitiva. Es una red interconectada de experiencias conformada por nuestras aspiraciones y emociones internas y por el contexto social y planetario más amplio en el que operamos. A diferencia de la Inteligencia Artificial, que destaca en el procesamiento de grandes conjuntos de datos, la Inteligencia Natural integra el significado, la ética y la adaptabilidad en la toma de decisiones.

La alfabetización de la Inteligencia Natural implica apreciar la naturaleza multidimensional de la inteligencia humana, que abarca la aspiración, la emoción, el pensamiento y la sensación, y reconocer cómo estas facetas individuales operan dentro de contextos sociales más amplios, desde la persona y la comunidad hasta el país y el planeta.

La alfabetización en Inteligencia Artificial implica comprender cómo funcionan los modelos de IA, incluidas sus limitaciones y sesgos inherentes, así como las consideraciones éticas que acompañan a su uso, como la posible propagación de información errónea y otras consecuencias no deseadas. También requiere reconocer cuándo confiar en los sistemas de IA frente a confiar en el juicio humano y mantenerse informado sobre la evolución de las capacidades y regulaciones de la IA.

Una comprensión de 360 grados del cerebro y del cuerpo, del yo y de la sociedad, combinada con una comprensión granular de la tecnología, mejora nuestro pensamiento crítico y nuestra capacidad de razonamiento moral. También nos prepara para asumir la responsabilidad personal de las decisiones y los resultados en una sociedad cada vez más híbrida, en la que miles de millones de personas siguen sin poder disfrutar ni siquiera de sus derechos humanos más fundamentales, como la educación.

Pensad que la inteligencia híbrida fusiona lo mejor de la Inteligencia Artificial y Inteligencia Natural. Las máquinas mejoran las capacidades humanas, mientras que los humanos inyectan juicio ético, empatía y una comprensión contextual más amplia en los procesos automatizados.

Hagámoslo bien. Saldremos ganando.

Y dicho esto, vamos con las recomendaciones…

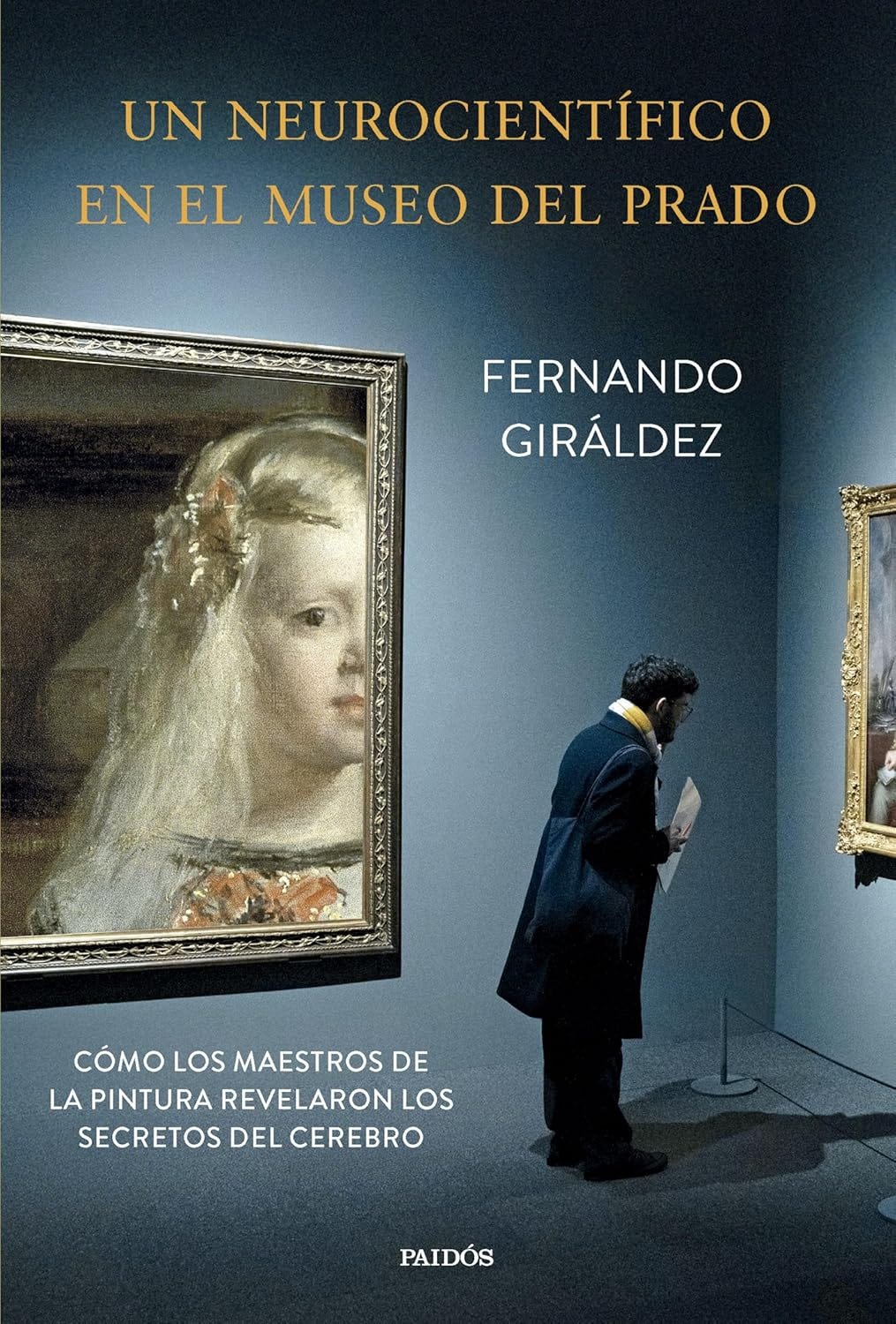

¿Un libro?

Un neurocientífico en el Museo del Prado, de Fernando Giráldez.

Un libro que es una invitación a mirar los cuadros de siempre con ojos nuevos: los de quien entiende que, detrás del lienzo, hay una exploración profunda, aunque inconsciente, de los misterios del cerebro.

A través de obras maestras de Velázquez, Sorolla, Tiziano o El Bosco, Fernando Giráldez nos revela cómo estos pintores lograron lo imposible: representar espacio, luz y movimiento en una superficie plana y estática. ¿La clave? Una intuición prodigiosa de cómo funciona nuestra percepción visual. Técnicas como el sfumato o la perspectiva aérea no solo eran recursos estéticos, sino auténticas herramientas para engañar nuestro cerebro y crear realidades ilusorias que sentimos casi más vívidas que el mundo real.

Este libro que no es solo de arte, es una celebración del vínculo entre ciencia y creatividad. Una demostración de que mirar un cuadro puede ser, también, una forma de entendernos a nosotros mismos.

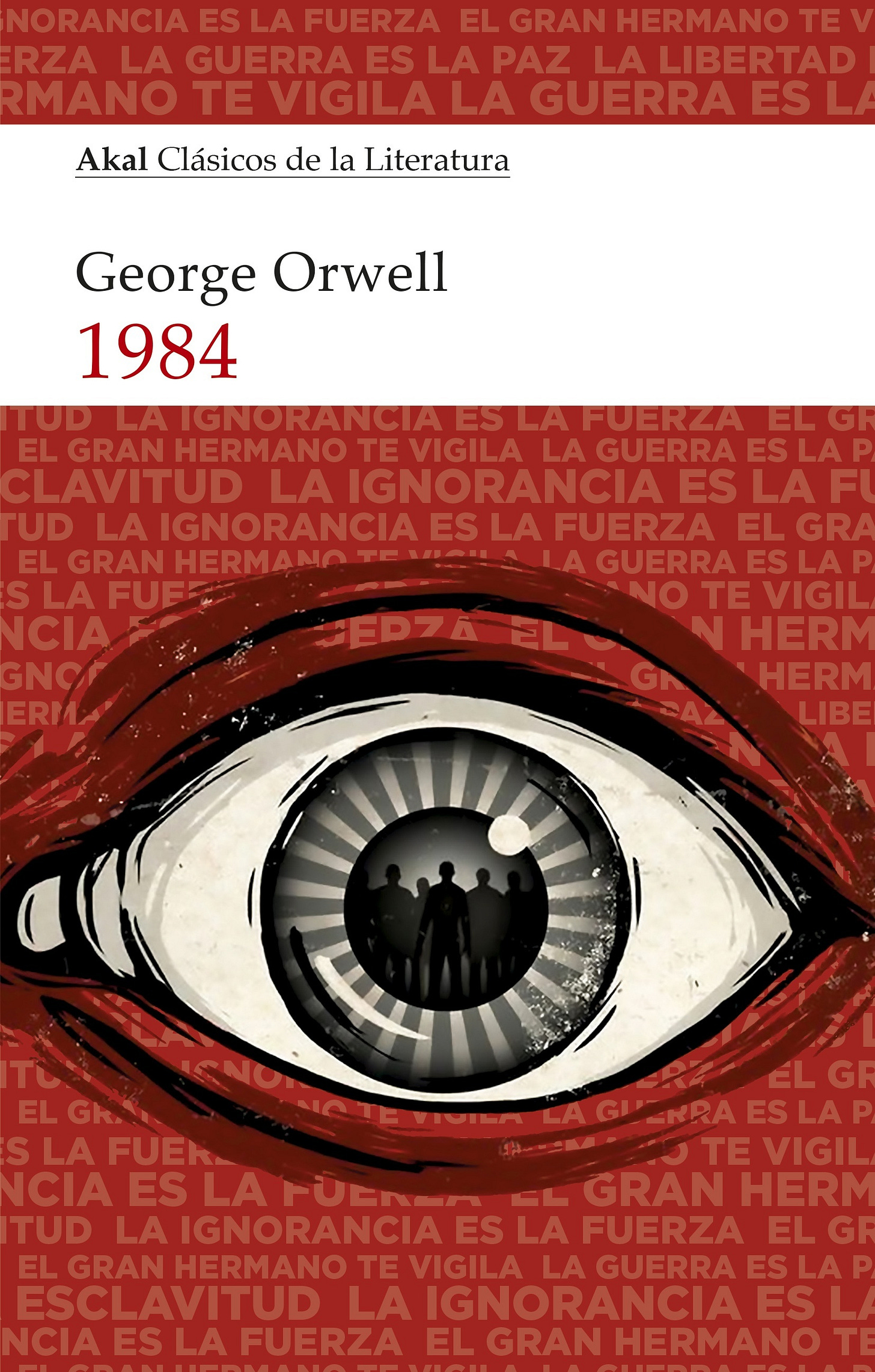

¿Un artículo?

1984, but with LLM’s, de Gary Marcus.

La ¿distopía? de Orwell en 1984, y que os recomiendo encarecidamente, se centra en el control total de la información por parte del Estado. Pero Gary Marcus nos lanza una nueva advertencia: hoy, no necesitamos un Gran Hermano para distorsionar la verdad, basta con un modelo de lenguaje mal supervisado. En su artículo plantea una reflexión urgente: ¿qué ocurre cuando herramientas tan poderosas como los LLM se integran masivamente en el flujo informativo sin mecanismos sólidos de validación?

La preocupación ya no es solo que las máquinas digan cosas incorrectas, sino que lo hagan de forma convincente, masiva y difícil de detectar. Marcus pone el foco en cómo estos modelos pueden generar y amplificar desinformación, intencionada o no, y en cómo esta posibilidad crece si se combinan con intereses comerciales o geopolíticos. Lo inquietante es que, en muchos casos, no hay supervisión humana efectiva ni rendición de cuentas clara.

Su propuesta no es apocalíptica, sino responsable: exige una gobernanza robusta, auditorías independientes y mecanismos de trazabilidad que aseguren transparencia y responsabilidad. Porque el riesgo no es la inteligencia artificial como tal, sino la ingenuidad humana frente a su potencial de manipulación. No estamos ante ciencia ficción, sino ante un desafío muy real: construir una IA que empodere… sin desinformar.

Marcus parece que se une también a esto de la inteligencia híbrida que hemos visto hoy y a cuidar y potenciar nuestro pensamiento crítico. Me alegro.

¿Otro artículo?

Brain Freeze, de Aurelia Song y Charlie Dever.

¿Es posible ganarle tiempo a la muerte? La criopreservación propone una idea tan sencilla como audaz: detener el deterioro del cuerpo justo después de la muerte para ganar tiempo hasta que la ciencia pueda devolverle la vida. A lo largo de décadas, investigadores han intentado perfeccionar una técnica que permita congelar el cuerpo sin dañarlo, especialmente el cerebro, donde reside nuestra identidad. El problema: aún no sabemos cómo ‘descongelar’ sin destruir. Sin embargo, sí somos capaces de conservar, con precisión atómica, la información sináptica que conforma una persona. Y eso, para algunos, ya es una forma de esperanza.

El artículo traza el recorrido desde los pioneros de los años 60, pasando por las caóticas primeras prácticas, hasta una nueva era más rigurosa liderada por científicos como Mike Darwin o Ken Hayworth. ¿El cambio clave? Pasar de intentar preservar la vida biológica a preservar la información: mantener intactas las conexiones sinápticas, como si se tratara de respaldar digitalmente una mente. Con técnicas como la vitrificación o el uso de fijadores químicos, hoy es posible preservar cerebros animales, y humanos, con una nitidez asombrosa. Pero solo si se actúa en menos de 12 minutos tras la muerte.

El verdadero enemigo no es la tecnología, sino el tiempo... y la legislación. Para que la criopreservación funcione, debe planearse antes de morir. El procedimiento requiere logística quirúrgica de precisión, equipos móviles y protocolos que la mayoría de los países no permiten legalmente. Hoy, solo en lugares como Oregón en USA, bajo leyes de muerte asistida, se dan las condiciones adecuadas. Así que sí, seguimos lejos de resucitar humanos... pero cada día más cerca de entender cómo preservar lo que realmente importa: la mente. Porque quizás la pregunta no es si podemos revivir a alguien, sino si podemos salvar su identidad para un futuro aún inimaginable.

‘We should send rockets not at each other, but rather to the stars’.

OK Jose Luis, nuestro sesgo humano puede confundir la elocuencia con la inteligencia genuina, tanto frente a otros humanos como a LLMs y eso con la explosión de la IA es un riesgo si damos por hecho que la IA actual no es realmente inteligencia, pero si hasta ahora hemos sobrevivido con este sesgo y dando por inteligentes a humanos que no lo eran, ¿por qué es realmente tan grave que demos por cierto de vez en cuando una respuesta de la IA incorrecta? ¿Cuántos médicos humanos han puesto en peligro a sus pacientes por diagnósticos incorrectos o cuantos accidentes de tráfico se podrían evitar si condujese una IA al igual que pilotan aviones (el medio de transporte más seguro estadísticamente)? Vale, las IAs actuales son todavía imperfectas pero su capacidad de almacenar datos y usarlos es ya muy superior al humano medio. No pretendo rebatir tus conclusiones tras leer el paper de Apple, solo comprenderlas mejor para poder transmitir el aprendizaje a mi hijo de 4 años, el cual seguro se enfrentará a un mundo en el que los humanos tengan “amigos” no humanos.

Fantastico!