IA, de Inteligencia Artificial a Integridad Artificial

A medida que las máquinas se vuelven mas 'inteligentes', es necesario que no solo funcionen bien, sino que también actúen con justicia y responsabilidad. La integridad debe ser la base de todo.

La lealtad de la Inteligencia Artificial reside en el código que hemos creado. Ésta es a la vez su potencial… y su peligro.

Tal y como la conocemos actualmente, la IA imita una forma de inteligencia, pero vacía. Carece de un núcleo moral. De hecho, durante décadas, hemos concebido y entrenado máquinas para calcular resultados, no para defender principios. Y viendo el avance, urge que arreglemos esto.

Por eso la próxima era del liderazgo debe adoptar lo que podríamos denominar Integridad Artificial, y que no es otra cosa que la fusión de la inteligencia con el razonamiento basado en principios.

Y es que si la historia nos enseña algo, es que el liderazgo flaquea sin claridad moral.

Ya no basta con crear sistemas que calculen el valor de algo más rápido que nunca o que se generen imágenes con una calidad inimaginable; debemos crear sistemas que comprendan valores. Porque la inteligencia desvinculada de los valores no es mejor que un barco sin quilla, que traza rumbo sin tener en cuenta las consecuencias.

La pieza que falta es la integridad, no la inteligencia. La inteligencia sin integridad es una historia sin moraleja. Es el factor que garantiza que las decisiones, tomadas por humanos, algoritmos o ambos, no sean meramente lógicas, sino éticas, morales, socialmente aceptables y responsables.

La integridad debe convertirse en la estrella polar de todo algoritmo, un requisito fundamental que garantice que la cualquier tecnología basada en Inteligencia Artificial no solo nos ayude, sino que nos ayude desde el bien. Eso significa una cosa muy sencilla: la integridad no es una característica; es la base arquitectónica de cualquier sistema que funcione, ya se trate de un sistema social, un sistema organizativo, un sistema humano o un sistema de IA.

Ahora que las máquinas acompañan a los humanos no sólo como herramientas, sino como agentes cognitivos, capaces de tomar decisiones, adaptarse y actuar, ahora que estamos entrando en una época en la que las máquinas no sólo nos asisten, sino que nos influyen, aprenden de nosotros y evolucionan a nuestro lado, no basta con preguntarse si un sistema así funciona. Debemos preguntarnos si funciona de forma ética y justa.

La cuestión ya no es si podemos construir máquinas ‘inteligentes’. Sabemos la respuesta. La cuestión ahora es si podemos garantizar que sean máquinas íntegras.

La próxima era exige algo más que máquinas inteligentes; exige máquinas capaces de razonar con integridad. Se trata de integrar el razonamiento ético, moral y social en los sistemas de IA.

El liderazgo debe defender esta redefinición.

Los líderes de hoy son los que ven no sólo lo que la IA puede hacer, sino lo que la IA debería hacer. Esta es la prueba definitiva para un liderazgo con futuro.

Exige un enfoque implacable, un compromiso inquebrantable y, sobre todo, la voluntad de desafiar el statu quo.

No se trata de control, sino de administración. Se trata de garantizar que los sistemas que creamos eleven a la humanidad en lugar de disminuirla. Que nos empoderen, que nos hagan mejores y más libres.

Se trata, como decía, de Integridad Artificial por encima de la Inteligencia Artificial, ya que ninguna cantidad de esta última sustituirá jamás la necesidad de la primera.

Este es el principio que transforma el liderazgo de la IA de un ejercicio de poder en un acto de servicio.

Imaginad un futuro en el que los gobiernos utilicen la IA para, por ejemplo, elaborar políticas que equilibren el crecimiento económico con la sostenibilidad. Estos sistemas no se limitan a analizar datos, sino que evalúan las implicaciones éticas, morales y sociales a largo plazo de las decisiones políticas.

Imaginad ahora plataformas educativas impulsadas por IA que no sólo se adapten al estilo de aprendizaje de cada alumno, sino que aborden activamente los sesgos sistémicos. Estos sistemas deben abogar por la igualdad de oportunidades, proporcionando a los estudiantes desfavorecidos recursos adaptados para colmar las lagunas educativas.

Imaginad también una inteligencia artificial aplicada al sector logístico que no solo optimice las rutas en aras de la eficiencia y el ahorro, sino que también dé prioridad a los métodos de entrega neutros en carbono, recomendando cambios hacia el uso de energías renovables y potenciando las cadenas de suministro locales para reducir la huella de carbono global.

Venga, un par de ejemplos más…

Un asesor financiero impulsado por IA que no se centre únicamente en maximizar los beneficios, sino que evalúe el impacto social y medioambiental de las inversiones, orientando a los clientes hacia un crecimiento económico sostenible y equitativo.

O coches autónomos, que no se limiten a evitar accidentes, sino que tomen decisiones éticas en tiempo real para dar prioridad a la seguridad de los usuarios más vulnerables de la carretera, como peatones, ciclistas y animales, basándose en un razonamiento sensible al contexto. Y que éstos circulen por una ciudad inteligente cuya planificación urbana se realiza con el uso de la Inteligencia Artificial, y que no se limita a optimizar las infraestructuras en función de la densidad de población, sino que aboga por la resiliencia frente a las catástrofes naturales, garantizando un acceso equitativo a los recursos durante las crisis y los esfuerzos de reconstrucción.

Sí, la integridad artificial es la nueva frontera, o eso espero, de la inteligencia artificial.

La cuestión no es sólo cómo hacemos que esto ocurra, sino qué nos impulsará a ello. Pero he de deciros que aunque el camino a recorrer pueda parecer ambicioso, ya se están plantando las semillas de esta transformación.

El enfoque de Anthropic para alinear los sistemas de IA con los principios éticos se encapsula en su concepto de Constitucional AI. Al integrar estos principios directamente en su proceso de desarrollo de la IA, Anthropic promueve una visión de la IA que no sólo sirve a las necesidades humanas, sino que lo hace de forma coherente con los valores.

Por su lado, Ilya Sutskever, cofundador y antiguo científico jefe de OpenAI, ha lanzado una nueva empresa llamada Safe Superintelligence Inc. (SSI). Y parece que gusta. Hace un par de meses, en septiembre, consiguió levantar 1.000 millones de dólares de destacados inversores. SSI se dedica a desarrollar sistemas de IA superinteligentes centrados principalmente en la seguridad y la alineación ética.

Y también OpenAI, en colaboración con la Universidad de Duke, está avanzando en la integración de la moralidad en los sistemas de IA a través de un proyecto llamado Research AI Morality, para desarrollar algoritmos que predigan los juicios morales humanos, haciéndolos conscientes de la integridad y alineados con los valores humanos.

Esto refleja el necesario cambio de liderazgo para abordar las implicaciones y los retos éticos, morales y de inteligencia social de las tecnologías de IA, garantizando que los sistemas de IA funcionen no sólo con Inteligencia, sino con Integridad.

Y esto exige más; mucho más liderazgo para abrazar este cambio, ya que el cambio hacia la Integridad Artificial por encima de la Inteligencia surgirá únicamente a través del poder de la distribución, no a través del de la concentración.

Un verdadero liderazgo preparado para la próxima era debe garantizar que las máquinas no solo trabajen para nosotros, sino que trabajen con nosotros, al tiempo que se alinean con nuestros ideales más elevados.

Para liderar este viaje, necesitamos visionarios, creadores y líderes que comprendan que los mayores logros son los que se basan en valores y en un sentido compartido del propósito. No se trata simplemente de construir máquinas más inteligentes; se trata de construir un mundo mejor.

Hay mucho trabajo, muchos retos que superar, pero hay algo que está claro: la integridad, no la inteligencia, es el nuevo objetivo.

Y dicho esto, vamos con las recomendaciones…

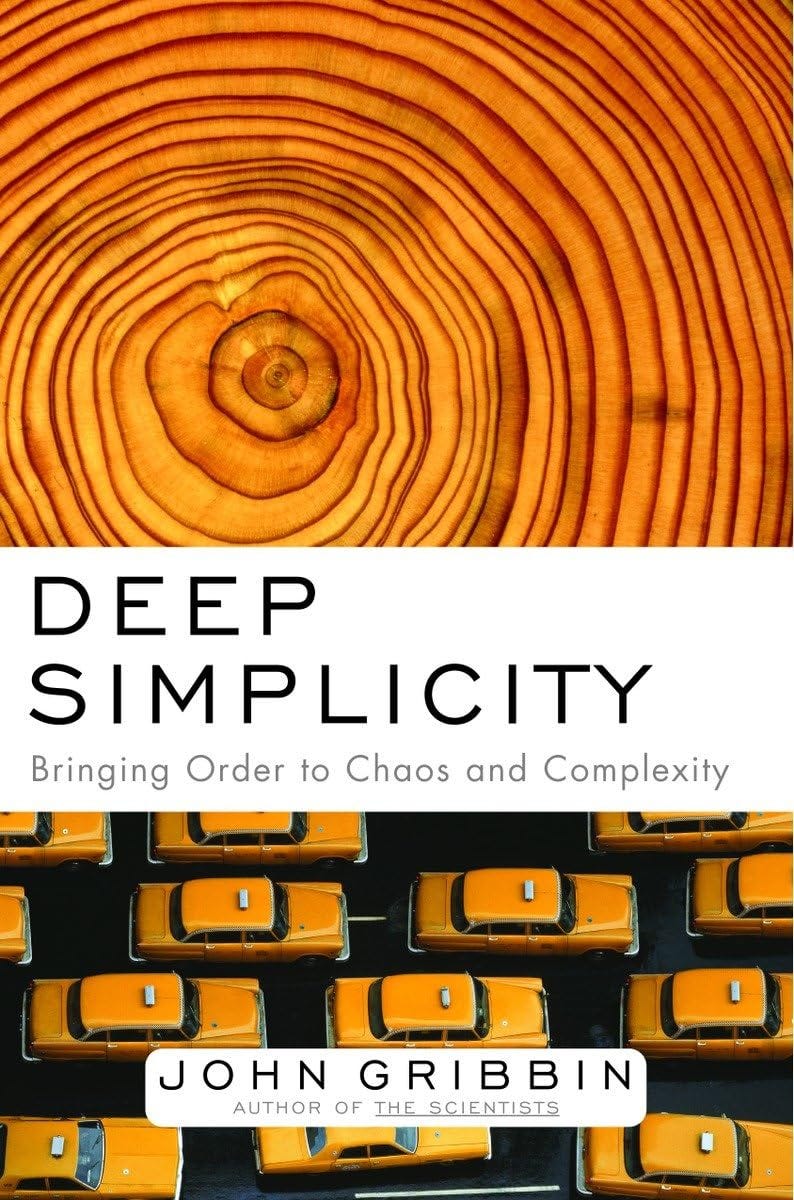

¿Un libro?

Deep Simplicity: Bringing Order to Chaos and Complexity, de John Gribbin.

Las pequeñas cosas que hacen que sucedan grandes cosas...

El mundo que nos rodea puede ser un lugar complejo y confuso. Los terremotos ocurren sin previo aviso, los mercados bursátiles fluctúan, los meteorólogos rara vez aciertan... incluso otras personas nos desconciertan. ¿Cómo le encontramos sentido?

John Gribbin nos revela que nuestro universo, aparentemente aleatorio, se basa en sencillas leyes de causa y efecto que explican, por ejemplo, por qué el frenazo de un solo vehículo puede provocar un atasco, por qué las tormentas desencadenan un ligero cambio atmosférico o incluso cómo evolucionamos a partir de los materiales más básicos. Como una pintura zen, una imagen fractal o el dibujo de las alas de una mariposa, los elementos simples forman la base de un todo sofisticado.

Un libro ameno y bien escrito. Buen regalo para estas Navidades, por cierto.

¿Otro libro?

Superconvergence: How the Genetics, Biotech, and AI revolutions will transform our lives, work, and world, de Jamie Metzl.

La Biotecnología, la Inteligencia Artificial y la Genética ya no son disciplinas aisladas y están camino de redefinir la humanidad tal y como la conocemos.

Este libro es una exploración audaz, inspiradora y multidisciplinar del conocimiento y las capacidades humanas de vanguardia, y de cómo aprovechar su asombroso potencial.

Jamie Metzl, destacado futurista y fundador de One Shared World, explora cómo la secuenciación del genoma, CRISPR, la inteligencia artificial y otras tecnologías no sólo están cambiando nuestras vidas, sino que se catalizan mutuamente de forma radical y acelerada. Estas tecnologías tienen el potencial de mejorar nuestra salud, alimentar a miles de millones de personas, sobrealimentar nuestras economías y almacenar información esencial durante millones de años, pero también pueden, si no tenemos cuidado, causar un daño inconmensurable. La ‘integridad’ artificial de la que hablo hoy en mi post, vuelve a la palestra ;)

El reto al que nos enfrentamos es que, mientras que la capacidad de diseñar el mundo que nos rodea avanza exponencialmente, nuestros procesos para comprender el alcance, la escala y las implicaciones de estos cambios sólo aumentan linealmente y nuestra capacidad para gobernar sabiamente nuestras capacidades divinas avanzan lentamente.

Otra fantástica lectura y estupendo regalo navideño.

¿Una reflexión?

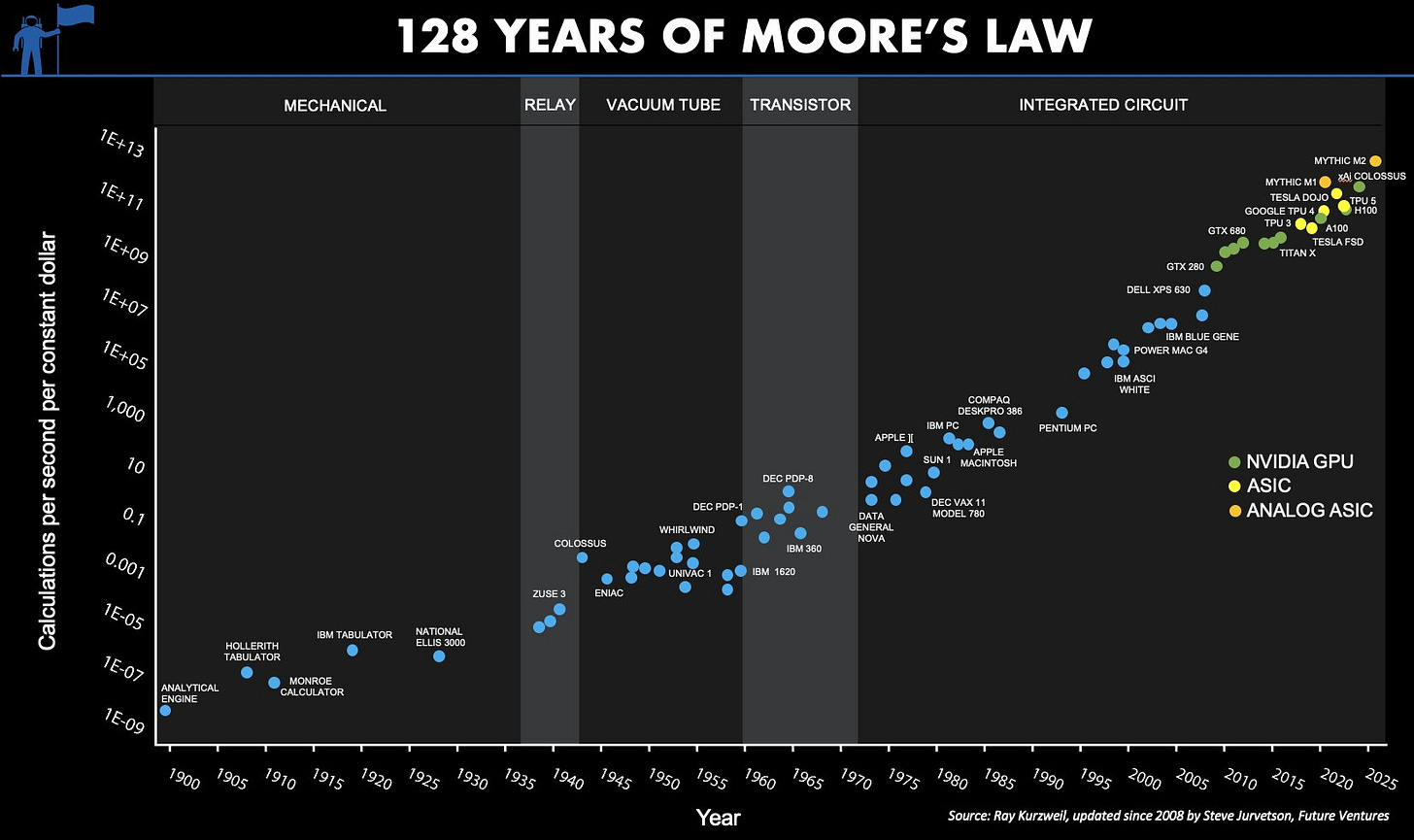

El otro día me topé con este gráfico que representa la Ley de Moore. Para el que no la conozca, y según cuenta la leyenda, esta ley empírica fue formulada por el cofundador de Intel, Gordon E. Moore en 1965 y viene a decir que cada 18 meses se duplica el número de transistores en un microprocesador y sirve para medir el avance tecnológico.

Pero aprovechando el gráfico os contaré algo: La Ley de Moore es a la vez una predicción y una abstracción. Y eso de que el número de transistores se duplica cada 18 meses, no es algo que haya dicho el cofundador de Intel. Es, eso sí, una buena combinación de sus dos predicciones: en 1965, predijo una duplicación anual de la cantidad de transistores en el chip más rentable de la época y la revisó en 1975 para que se produjera cada 24 meses. Con un poco de astucia, la mayoría de los informes atribuyen 18 meses a la Ley de Moore, pero hay bastante variabilidad. La percepción popular de la Ley de Moore es que los microprocesadores aumentan su complejidad a un costo unitario casi constante. Esta es una de las muchas abstracciones de la Ley de Moore y se relaciona con la composición de la densidad de transistores en dos dimensiones. Otras se relacionan con la velocidad, las señales tienen que viajar menos distancia, y la potencia computacional (velocidad x densidad).

A menos que trabajes para una empresa de chips y te centres en la optimización del rendimiento de las plantas de fabricación, no te interesan las cantidades de transistores. Los clientes de circuitos integrados no compran transistores. Los consumidores de tecnología compran velocidad computacional y densidad de almacenamiento de datos. Si se reformula en estos términos, la Ley de Moore ya no es una métrica centrada en los transistores, y esta abstracción permite un análisis a más largo plazo.

Lo que Moore observó en los inicios del sector fue una métrica derivada, una señal refractada de una tendencia a largo plazo, una tendencia que plantea varias preguntas filosóficas y predice futuros de IA alucinantes.

En la era moderna de cambios acelerados en la industria tecnológica, es difícil encontrar tendencias incluso de cinco años con algún valor predictivo, y mucho menos tendencias que abarquen siglos.

Yo iría más allá y afirmaría que este es el gráfico más importante jamás concebido. Un conjunto grande y creciente de sectores depende de continuas reducciones exponenciales de los costos de potencia computacional y densidad de almacenamiento. La Ley de Moore impulsa la electrónica, las comunicaciones y los ordenadores y se ha convertido en un impulsor principal en el descubrimiento de fármacos, la biotecnología y la bioinformática, la visión por computador aplicada a la medicina y el diagnóstico. A medida que la Ley de Moore cruza umbrales críticos, una ciencia que antes era de laboratorio y consistía en experimentación por ensayo y error se convierte en una ciencia de simulación, y el ritmo del progreso se acelera drásticamente, creando oportunidades para nuevos participantes en nuevos sectores.

Todas las empresas del sector que queráis se convertirán en un negocio basado en la información. ¿La agricultura? También. Si le preguntáis a un agricultor dentro de 20 años cómo compite, veremos que todo dependerá de cómo utilice la información, desde las imágenes satelitales que impulsan la optimización robótica del campo hasta el código de sus semillas. No tendrá nada que ver con la mano de obra o el trabajo. Y esto es algo que acabará filtrándose en todos los sectores a medida que la tecnología entre en todas las capas de la economía. Los cambios no lineales en el mercado también son esenciales para el espíritu emprendedor y el cambio. El ritmo exponencial del progreso tecnológico ha sido el principal motor de la disrupción perpetua del mercado, generando oleada tras oleada de oportunidades para nuevas empresas. Sin disrupción, los emprendedores no existirían.

La Ley de Moore no es sólo exógena a la economía; es la razón por la que tenemos crecimiento económico y un ritmo de progreso cada vez más acelerado. Vivimos tiempos interesantes, en la cúspide de las fronteras de lo desconocido y de avances asombrosos, lo que genera una sensación perpetua de conmoción por el futuro.

¿Un podcast?

¿Nos escuchan nuestros dispositivos móviles?

El pasado día 5 de noviembre tuve el gustazo de participar en La Tarde de la COPE de la mano de Pilar García Muñiz e Isra Remuiñán (GRACIAS!), y tocó hablar de algo que todos hemos sospechado alguna vez, pero que pocos pueden confirmar. ¿Nos escuchan los móviles y luego nos ponen anuncios sobre eso que han escuchado?

Técnicamente podrían hacerlo. Estos dispositivos están repletos de sensores, entre ellos micrófonos, que pueden captar fragmentos de conversaciones…, una conectividad que permite transmitir y procesar esa información, y que ésta se cruce con otro tipo de información, e intereses, y pueda hacer que recibamos publicaciones y publicidad orientada y personalizada… Por poder…

Además, existen evidencias de que empresas como Meta, Google y Amazon han recogido datos sin consentimiento explícito. ¿Recordáis cuando empleados de Amazon escuchaban conversaciones captadas por Alexa en 2019 con el fin de entrenar y mejorar las capacidades del asistente de voz?

Y con la legislación hemos topado pero, aunque los términos y condiciones incluyen menciones sobre el acceso al micrófono, la mayoría de los usuarios no lee estos documentos, lo que plantea dudas sobre la validez del consentimiento. Además, la falta de transparencia de estas empresas dificulta determinar si efectivamente escuchan o utilizan fragmentos de audio para fines publicitarios.

El caso es que aunque las empresas tecnológicas niegan explícitamente que los dispositivos móviles, asistentes de voz… escuchen conversaciones para personalizar la publicidad, la combinación de patrones observados, capacidades técnicas documentadas, unos incentivos económicos claros y algunos casos probados de abuso de datos, sugieren que existe al menos la posibilidad de que estas prácticas ocurran de forma limitada o encubierta.

¿Vosotros qué opináis?

Os dejo aquí el corte del programa:

You can fail at what you don’t want. So you might as well take a chance on doing what you love.